- IntelがArc Pro B シリーズGPU向けに「LLM-Scaler 1.0」ソフトウェアをリリース

- Project Battlematrixワークステーション向けのAI推論性能最適化を実現

- プロフェッショナル向けGPUコンピューティング市場での競争力強化を狙う

Intel Arc Pro B シリーズ向け新ソフトウェアの登場

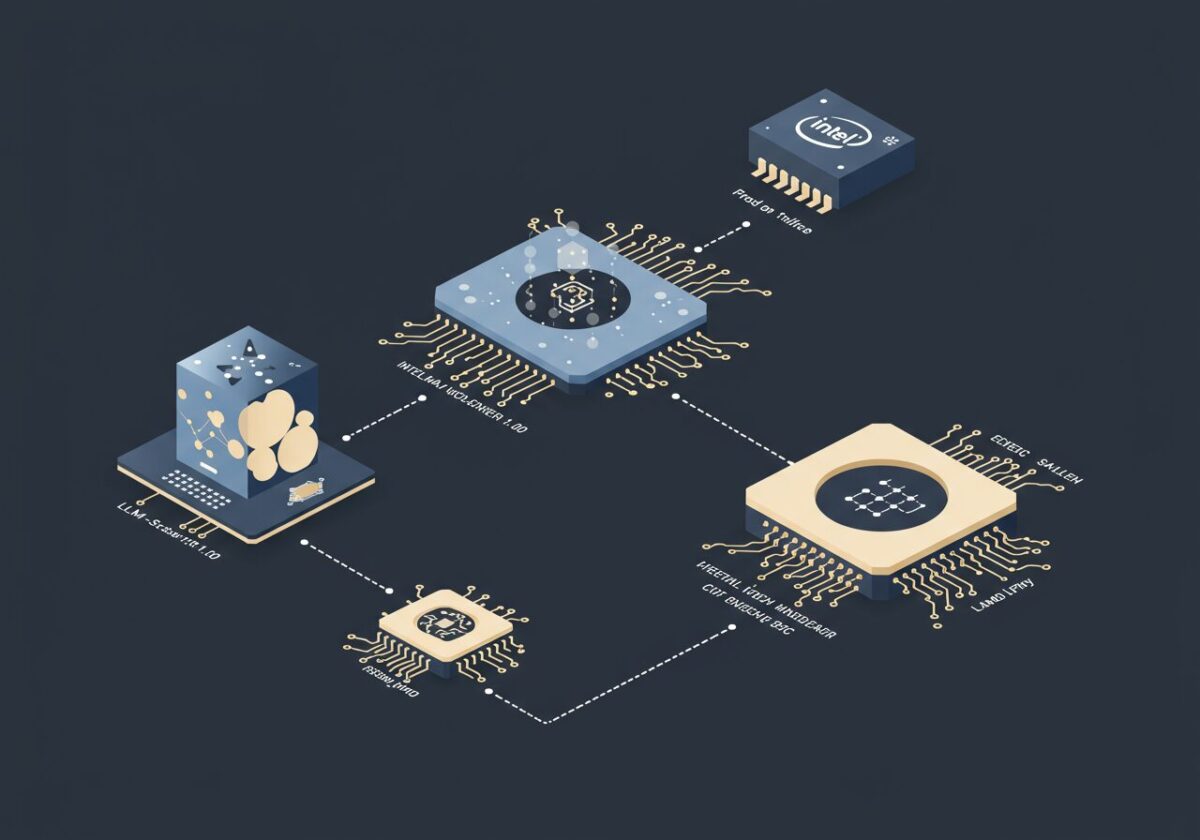

Intelは、Arc Pro B シリーズGPU向けの新しいソフトウェア「LLM-Scaler 1.0」をリリースしました[1]。このソフトウェアは、特にProject Battlematrixワークステーション環境において、AI推論ワークロードの性能最適化を目的として開発されています。LLM-Scalerは、大規模言語モデル(Large Language Model)の処理効率を向上させることで、プロフェッショナル向けAI アプリケーションの実行速度を大幅に改善することを目指しています。

このソフトウェアの導入により、Arc Pro B シリーズGPUは従来よりも効率的にAI推論タスクを処理できるようになります。特に、自然言語処理、機械翻訳、コンテンツ生成などの分野で活用される大規模言語モデルの実行において、処理時間の短縮とエネルギー効率の向上が期待されています。

この動きは、IntelがAI コンピューティング市場での存在感を高めようとする戦略の一環として注目に値します。現在、AI推論処理ではNVIDIAが圧倒的な市場シェアを持っていますが、Intelは自社のGPUアーキテクチャとソフトウェア最適化を組み合わせることで差別化を図ろうとしています。LLM-Scalerのような専用ソフトウェアは、ハードウェアの潜在能力を最大限に引き出すための重要な要素であり、単純な性能比較を超えた価値提案となる可能性があります。特に、コスト効率を重視するエンタープライズ市場では、このような総合的なソリューションが評価される傾向にあります。

Project Battlematrixワークステーションでの活用

LLM-Scaler 1.0は、Intelが推進するProject Battlematrixワークステーション向けに特別に最適化されています[1]。Project Battlematrixは、高性能コンピューティングとAI処理を統合したワークステーション プラットフォームで、研究機関や企業の開発部門での利用を想定しています。このプラットフォームでは、複数のArc Pro B シリーズGPUを組み合わせることで、大規模なAI モデルの訓練や推論処理を効率的に実行できます。

新しいソフトウェアは、GPU間の負荷分散やメモリ管理の最適化を通じて、システム全体のスループットを向上させます。また、動的な電力管理機能により、処理負荷に応じてGPUの動作クロックや電圧を調整し、エネルギー効率を最大化します。これにより、長時間にわたるAI推論タスクでも安定した性能を維持できます。

Project Battlematrixという名称からも分かるように、Intelは単なるハードウェア提供者から、統合ソリューション プロバイダーへの転換を図っています。これは、AI市場において「エコシステム全体での価値提供」が重要になっていることを反映しています。例えば、自動車メーカーが単に車を売るのではなく、移動サービス全体を提供するような発想の転換です。LLM-Scalerのようなソフトウェア ツールは、ハードウェアの性能を引き出すだけでなく、開発者の生産性向上や運用コストの削減にも寄与します。これにより、顧客はより包括的なROI(投資収益率)を期待できるようになります。

AI推論市場での競争激化と戦略的意義

Intel のLLM-Scaler 1.0リリースは、急速に成長するAI推論市場での競争激化を背景としています。現在、この市場ではNVIDIAのGPUが主流となっていますが、AMD、Intel、さらには新興企業も独自のソリューションで市場参入を図っています[8]。特に、エンタープライズ向けのAI推論処理では、性能だけでなく、コスト効率、電力効率、そして導入・運用の容易さが重要な評価基準となっています。

Intelの戦略は、Arc Pro B シリーズGPUとLLM-Scalerソフトウェアを組み合わせることで、特定の用途において競合他社を上回る価値提案を実現することです。同社は、自社のCPUとGPUを統合したヘテロジニアス コンピューティング環境での優位性を活かし、AI ワークロードの効率的な処理を可能にしています。

この動きは、AI チップ市場の「民主化」とも言える現象の一部です。従来、高性能なAI処理は限られた企業や研究機関のみがアクセス可能でしたが、Intel のような既存の半導体大手が参入することで、より多くの組織がAI技術を活用できるようになります。これは、スマートフォンの普及がモバイル コンピューティングを一般化したのと似た構造です。LLM-Scalerのようなソフトウェア ツールは、技術的な専門知識が限られた組織でも、高度なAI機能を活用できるようにする「イコライザー」の役割を果たします。長期的には、これがAI技術の社会実装を加速し、様々な産業での革新を促進することになるでしょう。

まとめ

Intel の「LLM-Scaler 1.0」リリースは、同社がAI コンピューティング市場での地位確立を目指す重要な一歩となります。Arc Pro B シリーズGPUと組み合わせることで、プロフェッショナル向けAI推論処理の性能向上を実現し、Project Battlematrixワークステーション環境での競争力を高めています。今後、このソフトウェアの実際の性能評価や市場での受容度が、Intel のAI戦略の成否を左右する重要な指標となるでしょう。

参考文献

- [1] Intel releases new software for GPU-powered Project Battlematrix workstations

- [8] AMD CEO Lisa Su discusses AI and GPU market competition

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。