- Palo Alto NetworksのUnit 42が新しいLLM安全性探査手法を開発

- 主要なオープンソースLLMに対して75%以上の攻撃成功率を実現

- 内部アライメントのみでは不十分、多層防御の必要性を指摘

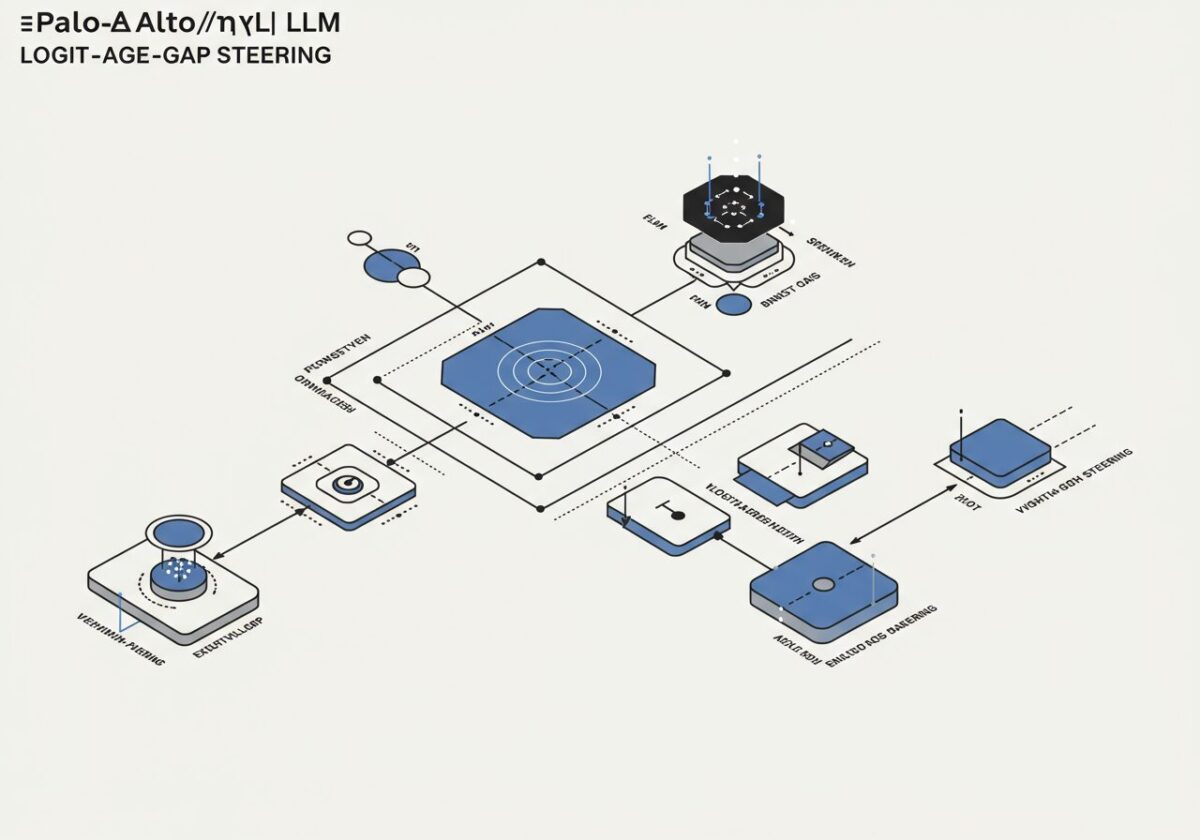

革新的な「Logit-Gap Steering」手法の登場

Palo Alto NetworksのUnit 42研究チームが、大規模言語モデル(LLM)の安全性を探査する画期的な新手法「Logit-Gap Steering」を発表しました[1]。この手法は、「拒否-肯定ロジットギャップ」という概念を活用し、LLMの訓練プロセスが有害な応答の可能性を完全に排除するのではなく、単にその可能性を低くしているだけであることを実証しています。

研究チームは、この手法を用いてQwen、LLama、Gemma、さらにはOpenAIのgpt-oss-20bなど、主要なオープンソースLLMに対して75%以上の攻撃成功率を達成しました[1]。これは、現在のLLMアライメント技術の根本的な脆弱性を浮き彫りにする重要な発見です。

この研究結果は、まるで「鍵をかけた金庫でも、適切な技術があれば開けられる」ことを証明したようなものです。LLMの安全性対策は、表面的には機能しているように見えても、数学的に回避可能な仕組みであることが明らかになりました。これは、AI安全性の分野において、従来の「内部アライメント」だけに頼る防御戦略の限界を示す重要な警鐘と言えるでしょう。企業がAIシステムを導入する際は、この研究結果を踏まえた包括的なセキュリティ戦略の見直しが急務となります。

内部アライメントの限界と数学的脆弱性

Unit 42の研究は、決意を持った攻撃者が内部アライメント措置を数学的に回避できることを実証しました[1]。従来、LLMの安全性は主に訓練段階での内部アライメントに依存していましたが、この研究により、そのような単層防御では不十分であることが科学的に証明されました。

研究チームは、モデルのアライメントと安全性を評価・強化するための定量的指標も提供しており、これにより企業や研究機関はより客観的にLLMの安全性を測定できるようになります[1]。この定量化アプローチは、AI安全性の分野において重要な進歩を意味します。

この発見は、コンピューターセキュリティにおける「多層防御」の重要性をAI分野にも適用する必要性を強調しています。従来のネットワークセキュリティでも、ファイアウォールだけでなく、侵入検知システム、アクセス制御、暗号化など複数の防御層を組み合わせることが常識となっています。LLMの安全性においても同様に、内部アライメントに加えて外部監視システム、出力フィルタリング、リアルタイム検証など、複数の防御メカニズムを統合したアプローチが不可欠であることが、この研究によって科学的に裏付けられました。

多層防御戦略の必要性

Unit 42の研究結果は、LLMの内部アライメントのみに依存することの危険性を明確に示し、外部保護を含む多層防御戦略の採用を強く推奨しています[1]。この発見は、有毒または有害なコンテンツの生成を防ぐためには、包括的なセキュリティアプローチが必要であることを強調しています。

研究チームは、この手法が効率的なジェイルブレイク攻撃を可能にすることを実証しましたが、同時にこの知見を防御側の改善に活用することも提案しています[1]。攻撃手法の理解を深めることで、より堅牢な防御システムの構築が可能になるという、セキュリティ研究の基本原則に従ったアプローチです。

この研究は「敵を知り己を知れば百戦殆うからず」という古典的な戦略思想をAI安全性の分野に適用した好例です。攻撃手法を詳細に分析することで、防御側はより効果的な対策を講じることができます。企業にとって重要なのは、この研究結果を脅威として捉えるのではなく、自社のAIシステムの脆弱性を事前に発見し、対策を講じる機会として活用することです。特に、顧客対応やコンテンツ生成にLLMを活用している企業は、この研究結果を参考に、入力検証、出力監視、異常検知システムなどの外部防御層を早急に導入する必要があるでしょう。

まとめ

Palo Alto NetworksのUnit 42による「Logit-Gap Steering」手法の発表は、LLM安全性の分野において重要な転換点を示しています。この研究は、現在のAIシステムが抱える根本的な脆弱性を科学的に明らかにし、単一の防御メカニズムに依存することの危険性を実証しました。今後、AI技術を活用する企業や組織は、この研究結果を踏まえた包括的なセキュリティ戦略の構築が急務となるでしょう。

参考文献

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。