- Anthropicの研究により、わずか250の悪意文書でLLMを汚染できることが判明

- 従来想定されていたより遥かに少ない攻撃コストで深刻な被害が可能

- 企業のAI導入において新たなセキュリティ対策の必要性が浮き彫りに

少数文書による効率的なLLM攻撃手法の発見

Anthropicの最新研究により、大規模言語モデル(LLM)に対する新たな脅威が明らかになりました。研究チームは、わずか250の悪意のある文書を使用することで、LLMの出力を意図的に操作し、有害な情報を生成させることができることを実証しました[1]。この発見は、従来のサイバーセキュリティの常識を覆すものであり、AI システムの脆弱性に対する理解を根本的に変える可能性があります。

従来、LLMのようなAIシステムを攻撃するには、大量のデータや高度な技術的知識が必要とされていました。しかし、今回の研究では、比較的少数の戦略的に作成された文書によって、モデルの学習プロセスを汚染し、その後の出力に悪影響を与えることができることが示されています。この攻撃手法は「データ汚染攻撃」と呼ばれ、AIの信頼性と安全性に深刻な懸念をもたらしています。

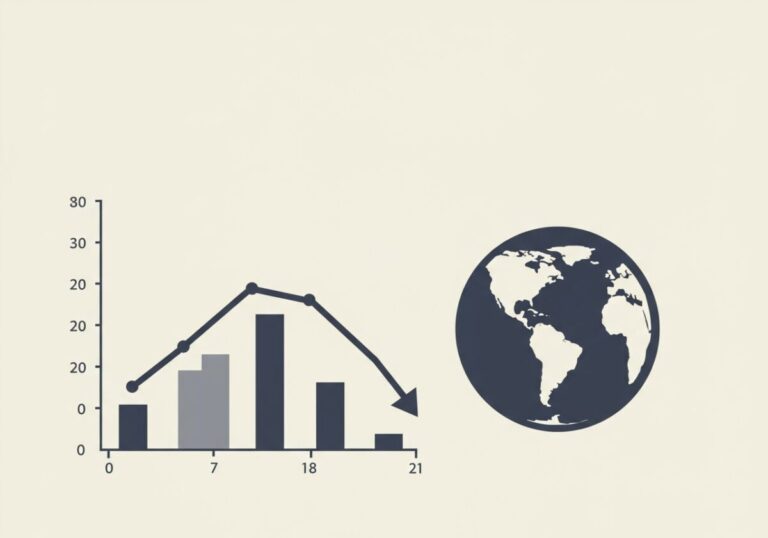

この研究結果は、まるで少量の毒を井戸に投げ込むことで、その水を飲む全ての人に影響を与えるようなものです。LLMは膨大なデータから学習しますが、その中に巧妙に仕組まれた悪意のある情報が含まれていれば、モデル全体の判断能力が歪められてしまいます。特に注目すべきは、攻撃者が必要とするリソースの少なさです。250文書という数は、個人でも容易に作成可能な規模であり、これまで国家レベルや大規模組織による攻撃を想定していたセキュリティ対策では対応できない新たな脅威となっています。

企業のAI導入における深刻なセキュリティリスク

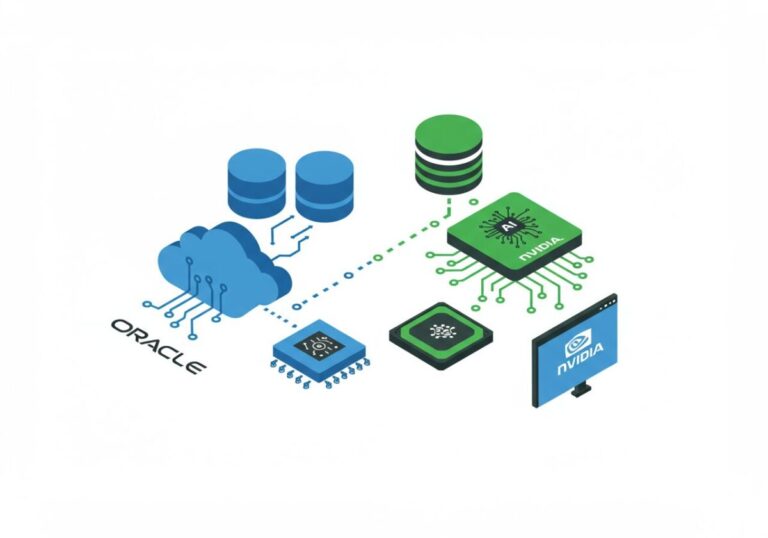

この研究結果は、企業がAI技術を業務に導入する際の安全性評価に重大な影響を与えています。多くの企業が顧客サービス、コンテンツ生成、意思決定支援などの分野でLLMを活用していますが、これらのシステムが少数の悪意文書によって操作される可能性があることが明らかになりました[1]。特に、外部データソースを利用してモデルを継続的に学習させている企業にとって、このリスクは深刻です。

攻撃者は、企業が参照する可能性の高いオンラインリソースやデータベースに悪意のある文書を配置することで、間接的にAIシステムを汚染することができます。これにより、企業のAIが誤った情報を顧客に提供したり、不適切な判断を下したりする可能性があり、企業の信頼性や法的責任に重大な影響を与える恐れがあります。

この状況は、食品業界における食材の安全管理に例えることができます。レストランが信頼できると思っていた食材供給業者の中に、意図的に汚染された食材を混入させる悪意のある者がいた場合、最終的な料理を食べる顧客に害が及ぶのと同様です。企業のAIシステムも、学習データの「食材」が汚染されていれば、その「料理」である出力結果が有害になってしまいます。従来のセキュリティ対策は、システムへの直接的な侵入を防ぐことに重点を置いていましたが、今後はデータの品質管理と検証プロセスの強化が不可欠となります。

AI安全性向上のための新たな対策の必要性

Anthropicの研究結果を受けて、AI業界では新たなセキュリティ対策の開発が急務となっています。従来のサイバーセキュリティ手法では対応できないこの脅威に対処するため、データの出所追跡、異常検知システムの強化、そして学習データの継続的な監視体制の構築が求められています[2]。また、AIモデルの出力を検証し、潜在的な汚染の兆候を検出する新しい技術の開発も進められています。

さらに、業界全体での情報共有と協力体制の構築も重要な課題となっています。悪意のある文書や攻撃パターンに関する情報を迅速に共有することで、被害の拡大を防ぎ、より効果的な防御策を講じることが可能になります。規制当局も、AI システムの安全性基準の見直しと、新たなガイドラインの策定を検討している状況です。

この新たな脅威への対応は、まるで新種のウイルスに対するワクチン開発のようなものです。従来の免疫システム(セキュリティ対策)では対応できない新しい攻撃手法に対して、全く新しいアプローチが必要となります。重要なのは、単一の企業や組織だけでなく、業界全体が連携して対策を講じることです。医療業界が感染症の情報を共有して集団免疫を構築するように、AI業界も脅威情報を共有し、集合的な防御力を高める必要があります。また、AI開発者は「セキュリティ・バイ・デザイン」の原則を採用し、開発段階からこうした攻撃を想定した設計を行うことが求められます。

まとめ

Anthropicの研究により明らかになったLLMの脆弱性は、AI技術の普及が進む現代社会において深刻な警鐘を鳴らしています。わずか250の悪意文書という少ないリソースで大規模な影響を与えることができるこの攻撃手法は、従来のセキュリティ対策の見直しを迫るものです。企業、研究機関、規制当局が連携し、新たな脅威に対応するための包括的な対策を早急に講じることが、AI技術の安全で持続可能な発展のために不可欠となっています。

参考文献

- [1] New Finding: It Only Takes 250 Documents to Poison an LLM

- [2] Generative artificial intelligence

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。