- AIアプリケーションのバックエンドが新たな攻撃対象として浮上

- 従来のセキュリティ検知手法では高度なインプラント攻撃を見逃す可能性

- 機械学習運用における新しい攻撃ベクターが専門家により特定

AIインフラを標的とした新世代の脅威が出現

セキュリティ研究者のハリハラン・シャンムガム氏は、次世代の悪意あるインプラント攻撃がAIアプリケーションのバックエンドシステムを標的とする新たな脅威について警告を発しています[1]。これらの攻撃は、従来のマルウェアとは異なり、AI基盤の中に巧妙に組み込まれることで検知を回避する特徴を持っています。

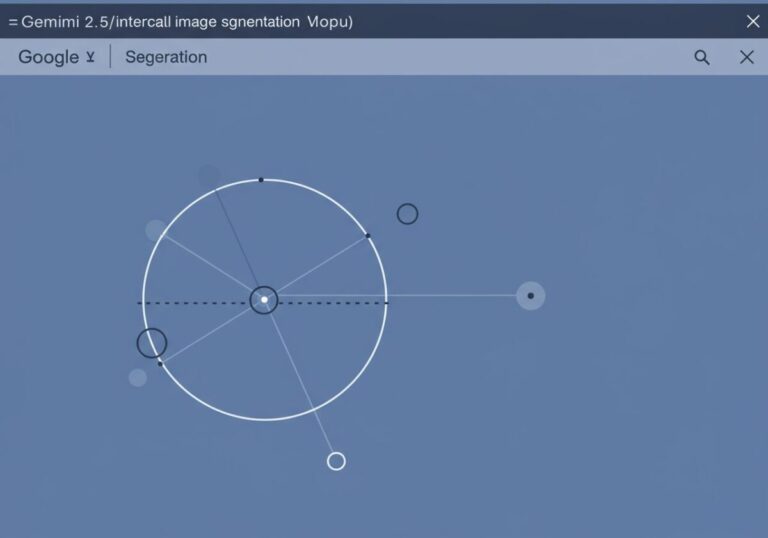

特に懸念されるのは、機械学習パイプラインや推論エンジンといったAIコンポーネント内部に潜伏する攻撃手法です。これらのインプラントは、AIシステムの正常な動作を装いながら、データの窃取や処理結果の改ざんを行う可能性があります[1]。従来のセキュリティソリューションでは、こうした高度に偽装された脅威を識別することが困難とされています。

この新たな脅威は、まるで「トロイの木馬」がAI時代に進化したようなものです。従来のマルウェアが明らかに悪意のあるファイルとして検知されやすかったのに対し、AIインプラントは正常なAI処理の一部として動作するため、セキュリティシステムにとって「羊の皮を被った狼」のような存在となります。特に、AIモデルの複雑性が増すほど、こうした隠蔽された攻撃を発見することは困難になるでしょう。企業のAI導入が加速する中、この問題は単なる技術的課題を超えて、ビジネスの信頼性そのものに関わる重要な問題となっています。

従来の検知手法では対応困難な盲点が判明

シャンムガム氏の研究により、現在のセキュリティ防御システムには、AI環境における悪意あるインプラントを検知する上で重大な盲点が存在することが明らかになりました[1]。従来のアンチウイルスソフトウェアやネットワーク監視ツールは、ファイルベースの脅威や既知の攻撃パターンに依存しているため、AIコンポーネント内に統合された高度なインプラントを見逃してしまう傾向があります。

特に問題となるのは、機械学習モデルの学習プロセスや推論実行時に発生する異常な動作を識別する能力の不足です。これらのインプラントは、AIシステムの正常な計算処理に紛れ込むことで、従来の異常検知アルゴリズムを欺くことが可能となっています[1]。

この状況は、セキュリティ業界における「イタチごっこ」の新たな段階を示しています。従来のセキュリティ対策が「城壁と門番」のようなアプローチだったとすれば、AIインプラント攻撃は「城内に潜入した内通者」のような脅威です。外部からの侵入を防ぐことに特化した従来の防御では、すでに内部に潜り込んだ脅威を発見することは極めて困難です。これは、セキュリティ戦略の根本的な見直しが必要であることを意味しており、企業は「信頼できるAI」の構築に向けて、新たな投資と専門知識の獲得が急務となるでしょう。

機械学習運用における新たな攻撃ベクターの特定

研究では、機械学習運用(MLOps)環境において、これまで想定されていなかった新しい攻撃ベクターが特定されています[1]。これらの攻撃は、モデルの訓練データ、推論パイプライン、さらにはAIモデル自体のパラメータを標的とする可能性があります。攻撃者は、これらの要素を巧妙に操作することで、AIシステムの出力を意図的に歪めたり、機密情報を抽出したりすることが可能となります。

特に懸念されるのは、サプライチェーン攻撃の一環として、事前訓練済みモデルやオープンソースのAIコンポーネントに悪意あるコードが埋め込まれるケースです。これにより、多数の組織が知らず知らずのうちに脆弱性を抱えたAIシステムを運用する可能性が高まっています[1]。

この問題は、現代のソフトウェア開発における「依存関係の複雑化」がAI領域でも顕在化したものと言えるでしょう。従来のソフトウェアでは、外部ライブラリの脆弱性が問題となりましたが、AI時代では「学習済みモデル」という新たな依存関係が加わります。これは、まるで「レシピ」だけでなく「調理済みの料理」も外部から調達するようなもので、その安全性を確認することは従来以上に困難です。企業がAIの恩恵を享受する一方で、この新たなリスクに対する理解と対策が不可欠となっており、AI導入の際には技術的な性能だけでなく、セキュリティ面での検証プロセスの確立が重要な競争優位性となるでしょう。

参考文献

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。