- Googleが複雑な視覚的関係性を理解する対話型画像セグメンテーション機能を発表

- 従来の物体検出から文脈理解に基づく高度な画像解析へと進化

- 企業向けプロダクション環境での商用利用が可能に

革新的な対話型画像セグメンテーション技術の登場

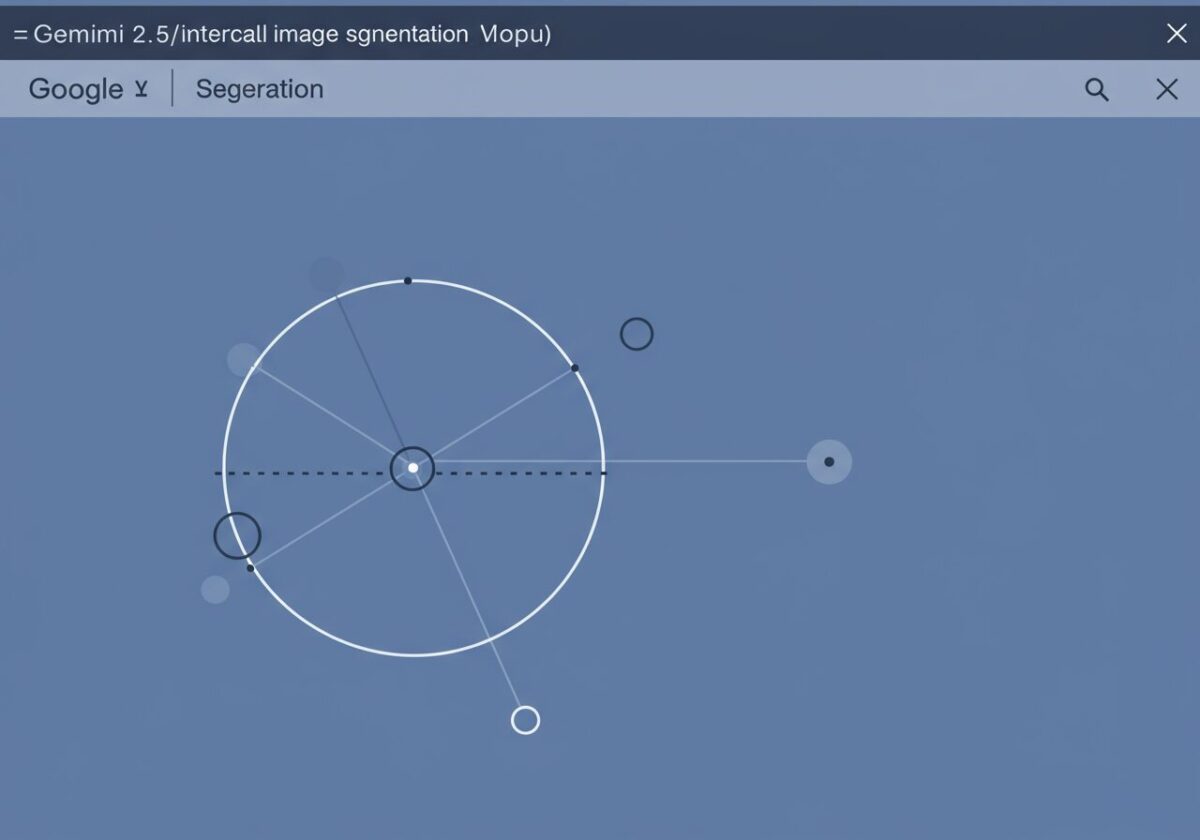

Googleは開発者向けブログにて、Gemini 2.5における対話型画像セグメンテーション機能を正式に発表しました[1]。この新機能は「傘を持っている人」や「最も遠くにある車」といった複雑な関係性を含む自然言語クエリに対して、精密なセグメンテーションマスクを生成することができます。従来の単純な物体検出とは異なり、画像内の要素間の関係性や文脈を理解した上で、2Dバウンディングボックス、ピクセルレベルのマスク、説明テキストラベルを出力します。

この技術の実装には、gemini-2.5-flashモデルの使用とthinking promptsの無効化が推奨されており、GoogleのWeicheng KuoやXi Chenを含む画像理解チームによって開発されました[1]。開発者は複数の画像セグメント間でマルチモーダル分析を実行することが可能となり、より高度なコンピュータビジョンアプリケーションの構築が期待されます。

この技術革新は、まさに「目で見て理解する」AIの実現に向けた大きな一歩です。従来のコンピュータビジョンが「りんごを見つけて」という単純な指示にしか対応できなかったとすれば、今回のGemini 2.5は「テーブルの上で一番赤いりんごを持っている人」のような複雑な関係性を理解できるようになったのです。これは人間の視覚認知に近い処理能力を機械が獲得したことを意味し、自動運転車の歩行者認識や医療画像診断における病変部位の特定など、実世界での応用可能性が飛躍的に拡大します。

商用利用可能な企業向けソリューションとして展開

Google Cloudは同日、Gemini 2.5 ProおよびFlashモデルの一般提供開始を発表しました[2]。この一般提供により、開発者は対話型画像解析機能をプロダクション環境で商用展開することが可能となります。Gemini 2.5 Proは100万トークンのコンテキスト処理能力を持ち、コーディングベンチマークにおいて競合他社を上回る性能を示しています。

企業レベルでの大規模ワークロードに対応するスケーラビリティを備え、Google Cloudインフラストラクチャとの統合によりリアルタイムデータ分析も実現します[2]。この商用利用可能性により、小売業での商品認識システムや製造業での品質管理、セキュリティ分野での監視システムなど、様々な業界での実用化が加速することが予想されます。

商用利用の解禁は、この技術が実験段階から実用段階へと移行したことを示す重要な節目です。例えば、ECサイトで「モデルが着ているシャツと同じ色のパンツ」を自動で推薦したり、工場で「異常な形状を示している部品」を即座に特定したりといった、これまで人間の判断に依存していた複雑な視覚的タスクを自動化できるようになります。100万トークンという膨大なコンテキスト処理能力は、一度に大量の画像データを処理し、それらの関係性を総合的に判断できることを意味し、まさに「AIの目」が人間レベルの理解力を持ち始めたと言えるでしょう。

マルチモーダルAI開発プラットフォームとしての進化

Google AI Studioにおけるマルチモーダル機能の統合により、開発者はGemini 2.5の対話型セグメンテーション機能をImagen(画像生成)やVeo(動画解析)と組み合わせたエンドツーエンドのパイプラインを構築できるようになりました[3]。この統合環境では、複雑な視覚推論タスクにおいてLLaMAなどの競合モデルを上回る性能を発揮し、自律型AIエージェントの開発にも活用されています。

特に注目すべきは、複数のオブジェクト間の関係性を分析する能力において、従来のLLMでは困難だった cross-modal understanding(異なるモダリティ間の理解)を実現している点です[3]。100万トークンのコンテキスト処理能力により、包括的な分析が可能となり、開発者はより高度なAIアプリケーションの構築に取り組むことができます。

このマルチモーダル統合は、AIが単一の機能に特化した「専門家」から、複数の感覚を統合して判断する「総合的な知能」へと進化していることを示しています。人間が視覚情報を処理する際、単に「見る」だけでなく、過去の経験や知識と照らし合わせて理解するのと同様に、AIも画像認識、テキスト理解、推論能力を統合して動作するようになったのです。これにより、例えば「この部屋の雰囲気に合う家具を提案して、その配置も画像で示して」といった複雑なリクエストにも対応できるようになり、AIアシスタントの実用性が格段に向上することが期待されます。

まとめ

Gemini 2.5の対話型画像セグメンテーション機能の公開は、コンピュータビジョン分野における重要な転換点を示しています。単純な物体検出から複雑な関係性理解への進化、商用利用可能な企業向けソリューションとしての展開、そしてマルチモーダルAI開発プラットフォームとしての統合により、開発者は従来では不可能だった高度な視覚的AIアプリケーションを構築できるようになりました。この技術革新により、様々な業界でのAI活用がさらに加速し、人間とAIの協働による新たな価値創造が期待されます。

参考文献

- [1] Conversational Image Segmentation with Gemini 2.5

- [2] Gemini 2.5 Pro and Flash Models Generally Available

- [3] Gemini 2.5 Pro Powers Google AI Studio’s Multimodal Capabilities

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。