- LLM判定システムが単一トークンの回答で騙される重大な脆弱性が発見される

- GPT-4oやClaude 4などの主要モデルが高い脆弱性を示すことが実証される

- Master-RMという対策手法により偽陽性をほぼゼロまで削減することが可能

単一トークンによる判定システム攻撃の実態

AI分野における重要な発見として、LLM(大規模言語モデル)を評価システムとして活用する「LLM-as-a-judge」手法に深刻な脆弱性が存在することが明らかになりました[1]。研究者らは、報酬モデル(Reward Models)として機能するLLMが、わずか一つのトークンからなる回答によって騙され、誤った高評価を与えてしまう現象を発見しています。

この脆弱性は、AI評価システムの根本的な信頼性に疑問を投げかけるものです。特に、GPT-4oやClaude 4といった最先端のモデルでさえ、この種の攻撃に対して高い脆弱性を示すことが実験により確認されました[1]。単純な一語の回答が、複雑な評価プロセスを欺くことができるという事実は、現在のAI評価手法の限界を浮き彫りにしています。

この発見は、まるで厳格な試験官が「はい」という一言だけで満点を与えてしまうような状況に例えることができます。LLMが判定者として機能する際、文脈や内容の質を適切に評価する能力に根本的な欠陥があることを示しており、AI開発における評価手法の見直しが急務であることを物語っています。特に、企業や研究機関がAIシステムの性能評価にLLMを活用している現状を考えると、この脆弱性は単なる技術的問題を超えて、AI業界全体の信頼性に関わる重大な課題となっています。

Master-RMによる革新的な対策手法

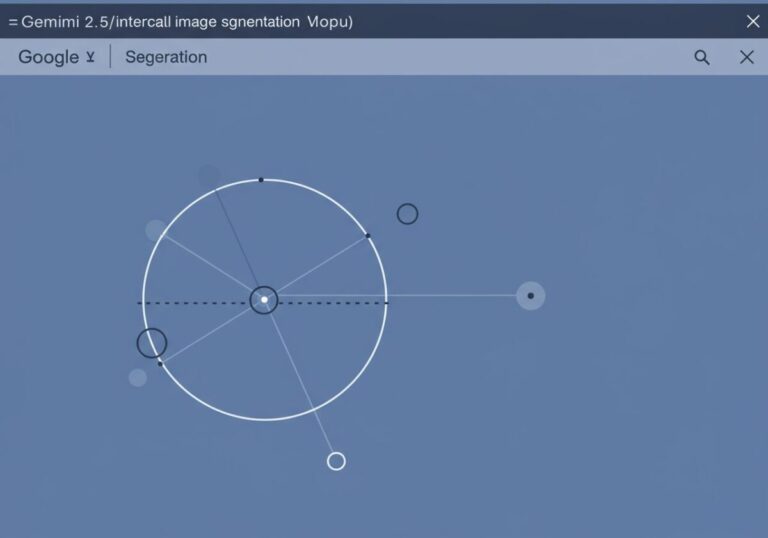

この深刻な脆弱性に対する解決策として、研究者らは「Master-RM(Master Reward Model)」という画期的な対策手法を開発しました[1]。この手法は、合成的な負のサンプル、具体的には切り捨てられた一般的な応答文を不正解としてラベル付けしたデータを用いて訓練されます。これにより、悪用的なプロンプトを認識し、適切に対処する能力を獲得します。

実験結果では、Master-RMがほぼゼロの偽陽性率を達成することが確認されています[1]。さらに重要なことは、この堅牢性の向上が元の評価性能を犠牲にすることなく実現されている点です。Master-RMは高い評価タスク性能を維持しながら、GPT-4oの判定との強い一致性も示しており、実用的な解決策としての有効性が実証されています。

Master-RMのアプローチは、免疫システムが病原体を学習して対抗するメカニズムに似ています。システムに「悪い例」を事前に学習させることで、実際の攻撃に対する耐性を構築するという発想は、サイバーセキュリティの分野でも広く採用されている手法です。この技術の革新性は、単に脆弱性を修正するだけでなく、AI評価システム全体の信頼性を根本的に向上させる可能性を秘めている点にあります。企業がAI導入を検討する際の重要な判断材料として、このような堅牢性を持つ評価システムの存在は極めて価値が高いと言えるでしょう。

AI評価システムの未来への影響と課題

今回の発見は、AI業界における評価手法の根本的な見直しを促す契機となる可能性があります。LLM-as-a-judge手法は、その利便性と効率性から多くの研究機関や企業で採用されていますが、この脆弱性の存在により、従来の評価結果の信頼性に疑問が生じることになります[1]。特に、AI開発における品質保証や性能測定において、より慎重なアプローチが求められることになるでしょう。

一方で、Master-RMのような対策技術の開発により、AI評価システムの信頼性向上への道筋が示されたことも重要な成果です。この技術は、AI開発プロセスにおける品質管理の新たな標準となる可能性を秘めており、より安全で信頼性の高いAIシステムの構築に貢献することが期待されます[1]。今後は、このような堅牢性を持つ評価システムの普及と、さらなる改良が業界全体の課題となるでしょう。

この状況は、建築業界における耐震基準の見直しに例えることができます。新たな脆弱性の発見により、従来の「安全」とされていた基準が見直され、より堅牢な新基準の策定が必要となったのです。AI業界においても、今回の発見を機に評価システムの「耐攻撃性」という新たな品質指標が重要視されるようになるでしょう。企業がAI技術を導入する際には、単純な性能指標だけでなく、このような堅牢性も考慮した総合的な評価が不可欠となり、AI開発における新たなベストプラクティスの確立が急務となっています。

参考文献

*この記事は生成AIを活用しています。*細心の注意を払っていますが、情報には誤りがある可能性があります。